Oznaczanie treści generowanych przez AI

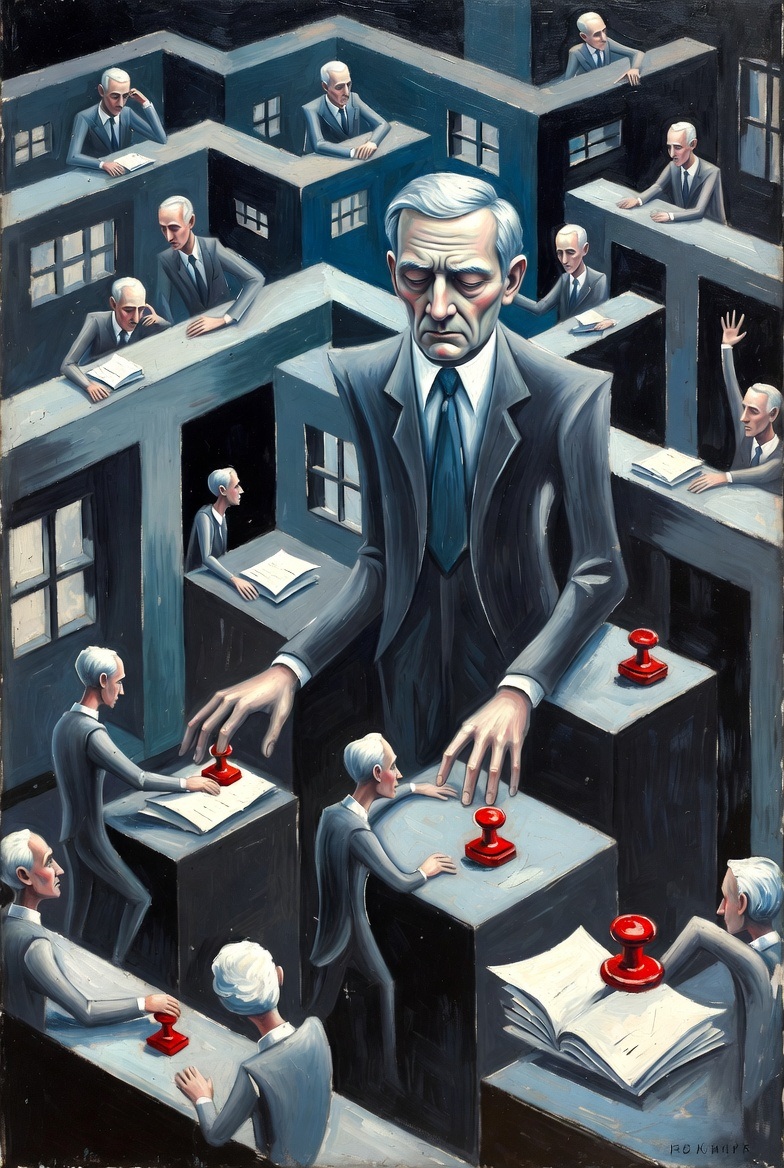

Wodny znak Syzyfa. Rozważania nad najnowszym arcydziełem regulacyjnym Unii Europejskiej.

Jest coś niemal wzruszającego w wierze Komisji Europejskiej w biurokrację.

Kiedy reszta świata ściga się, by zbudować sztuczną inteligencję ogólną, Bruksela wykorzystała swoją własną inteligencję — tę całkowicie naturalną, jak można przypuszczać — aby wyprodukować trzydziestodwustronicowy dokument wyjaśniający, jak nakleić małą naklejkę „AI” na fotografię.

Pierwszy Projekt Kodeksu Postępowania w sprawie Przejrzystości Treści Generowanych przez AI przybywa z fanfarami, jakich oczekuje się po dokumencie utworzonym przez komitet szczycącym się sześcioma przewodniczącymi i wiceprzewodniczącymi (zrównoważonymi pod względem płci, zróżnicowanymi geograficznie, niezależnie wybranymi za ich wiedzę ekspercką w… przewodniczeniu). Reprezentuje, jak nam powiedziano, „unikalny” i „wspólny wysiłek z udziałem setek uczestników”.

Człowiek drży na myśl, co mógłby wyprodukować wysiłek niewspólny. Może tylko dwadzieścia osiem stron?

Dokument jest kolejną odsłoną implementacji Aktu o sztucznej inteligencji (AI Act)

Kodeks postępowania w zakresie oznaczania i etykietowania treści generowanych przez sztuczną inteligencję

Dokument otwiera się zwyczajowym odkaszlnięciem na temat „człowiekocentralnej i godnej zaufania sztucznej inteligencji” oraz ochrony „demokracji, praworządności i ochrony środowiska” — ponieważ nic nie wyraża hasła „zrównoważony rozwój” lepiej niż nakaz, by każdy obraz wygenerowany przez AI niósł wiele warstw niewidzialnych znaków wodnych, podpisów kryptograficznych, haszy percepcyjnych, manifestów metadanych i dzienników fingerprinting.

Ślad węglowy pojedynczego oznakowanego JPEG może wkrótce dorównać śladowi małego nadbałtyckiego państwa.

Ale nie bądźmy niesprawiedliwi. Autorzy zidentyfikowali prawdziwy problem: ludzie nie zawsze potrafią odróżnić treści wygenerowane przez AI od autentycznych materiałów. Ich rozwiązanie? Wymagać od dostawców AI osadzania tylu znaczników, że przyszli archeolodzy będą w stanie zidentyfikować mema z kotem z 2026 roku po jego siedemnastu odrębnych warstwach pochodzenia.

Proponowane „wielowarstwowe podejście” obejmuje:

- Metadane czytelne maszynowo (na wypadek, gdyby maszyny czuły się wykluczone)

- Niepostrzegalne znaki wodne „wplecione w treść”

- Bazy danych fingerprinting

- Obiekty logujące

- Cyfrowo podpisane manifesty

- Znaczniki strukturalne „zakodowane w wagach podczas trenowania modelu”

- I wreszcie, dla istot ludzkich, którym to rzekomo służy, mała ikonka

Wyobraźmy sobie przeciętnego obywatela, skonfrontowanego z podejrzaną fotografią polityka ściskającego dłoń kosmicie, starannie ekstrahującego metadane C2PA, krzyżowo sprawdzającego hash percepcyjny z współdzielonym zagregowanym weryfikatorem, dekodującego strukturalny znak wodny i wreszcie — uspokojony — odnotowującego małą plakietkę „AI” w rogu.

Jak oznaczać treści generowane przez AI?

Grupa Robocza 2 wniosła coś, co można opisać jedynie jako triumf myślenia kategorialnego. Treść musi być teraz klasyfikowana jako „W pełni wygenerowana przez AI” lub „Wspomagana przez AI”, przy czym ta ostatnia obejmuje tak szczegółowe rozróżnienia jak „filtry upiększające, które zmieniają postrzegany wiek i/lub ton emocjonalny” oraz „korekty kolorów, które zmieniają kontekstowe znaczenie (np. odcień skóry)”.

Zatrzymajmy się, by docenić szczegółowość. Każdy nastolatek stosujący filtr Valencia do swojego selfie na Instagramie jest teraz zaangażowany w manipulację treścią wspomaganą przez AI, która „może fałszywie wyglądać na autentyczną lub prawdziwą”. Implikacje dla samej europejskiej fotografii plażowej są oszałamiające.

Dokument pomocnie wyjaśnia, że „pozornie małe zmiany AI, które zmieniają kontekst treści (np. usunięcie szumu, które sprawia, że wydaje się, iż rozmówca znajduje się w innym otoczeniu)” wymagają ujawnienia. Inżynierowie dźwięku, którzy spędzili dekady usuwając tło z nagrań, mogą chcieć skonsultować się z prawnikami.

Ikona AI – Jakie działania będą wymagały oznaczania AI?

Żadna regulacja UE nie byłaby kompletna bez logo, i tutaj autorzy przeszli samych siebie. Proponowana ikona — okrąg zawierający litery „AI” — została poddana czemuś, co wygląda na rozległe deliberacje. Rysunek 1 w załączniku dumnie ogłasza, że została wygenerowana przez „zero-shot prompt w bezpłatnej wersji ChatGPT na grudzień 2025″, co nieco podważa powagę przedsięwzięcia.

Ikona musi być:

- „Wyraźnie widoczna w momencie pierwszej ekspozycji”

- „Umieszczona w pozycji odpowiedniej dla formatu treści”

- Wdrożona „w sposób, który nie zakłóca korzystania z dzieł artystycznych, kreatywnych, satyrycznych lub fikcyjnych”

- Dostępna w „dwuliterowym akronimie odnoszącym się do sztucznej inteligencji, który może również stanowić litery odnoszące się do tłumaczenia na języki państw członkowskich (np. AI, KI, IA)”

Możliwość, że „IA” może być mylone z Iowa, lub „KI” z jodkiem potasu, nie wydaje się niepokoić grup roboczych.

Dla treści tylko audio rozwiązanie jest jeszcze bardziej eleganckie: „powtarzające się słyszalne zastrzeżenia na początku i w fazach pośrednich oraz na końcu treści”. Wyobrażamy sobie deepfake’owy podcast przerywany co kilka minut uroczystym głosem intonującym: „Następująca treść została sztucznie wygenerowana lub zmanipulowana zgodnie z Art. 50(4) Rozporządzenia (UE) 2024/1689.”

Wyjątek, który połyka regułę

Zagrzebany w labiryntowym tekście jest przepis o niemal komicznej szerokości. Tekst wygenerowany przez AI nie wymaga ujawnienia, jeśli „przeszedł proces ludzkiego przeglądu lub kontroli redakcyjnej i gdy osoba fizyczna lub prawna ponosi odpowiedzialność redakcyjną”.

Innymi słowy: jeśli człowiek przeczyta wynik AI przed publikacją, etykieta nie jest wymagana.

Trudno wyobrazić sobie scenariusz, który to wyklucza. Zbuntowany algorytm, osiągnąwszy świadomość, autonomicznie publikuje felietony w Le Monde bez żadnego człowieka klikającego „wyślij”? System zarządzania treścią gazety staje się samoświadomy i zaczyna generować artykuły o posiedzeniach lokalnych rad? Autorzy najwyraźniej przygotowali się na każdą ewentualność z wyjątkiem prawdopodobieństwa.

Interoperacyjność, czyli Wieża Babel na wspak

Kodeks poświęca znaczną uwagę „interoperacyjności” — wymogowi, by systemy znakowania i wykrywania działały „w różnych kanałach dystrybucji i środowiskach technologicznych, niezależnie od domeny aplikacji lub kontekstu”.

Jest to, w zasadzie, godne pochwały. W praktyce oznacza to, że każdy dostawca AI w Europie musi wdrożyć kompatybilne schematy znakowania wodnego, współdzieloną infrastrukturę weryfikacji i ustandaryzowane formaty metadanych — jednocześnie zapewniając, że te systemy są „odporne” na „ataki amortyzacyjne”, „ataki regeneracyjne” i wszechobecne zagrożenie „typowymi operacjami przetwarzania takimi jak odbicie lustrzane, przycinanie, kompresja, przechwytywanie ekranu, parafrazowanie, usuwanie znaków, zmiany rozdzielczości obrazu lub wideo, przesuwanie wysokości dźwięku, rozciąganie czasu lub zmiana formatu”.

Dokument przyznaje, z odświeżającą szczerością, że „żadna pojedyncza technika aktywnego znakowania nie wystarcza w momencie tworzenia Kodeksu, aby spełnić wymagania prawne”. Tłumaczenie: technologia zgodności z tymi zasadami nie istnieje. Ale zasady istnieją, i to się liczy.

Czy zawsze należy oznaczać materiały wytworzone przez AI?

W całym dokumencie autorzy gestykulują w kierunku „proporcjonalności dla MŚP i małych spółek o średniej kapitalizacji”. Uproszczona zgodność dla startupów, zapewnia się nas, „powinna być możliwa”.

Natura tego uproszczenia pozostaje tajemnicza. Środek 4.1 wymaga od wszystkich wdrażających „ustanowienia i wdrożenia wewnętrznych procesów identyfikacji deepfake’owych obrazów, audio, treści wideo” i ustalenia, czy mają zastosowanie wyjątki. Środek 2.2 nakazuje „odpowiednie szkolenie personelu” w zakresie stosowania taksonomii, praktyk ujawniania, wymagań dostępności i procedur korekty. Środek 4.2.5 określa różne wymagania ujawniania dla treści audio „krótszych niż 30 sekund” w porównaniu z „dłuższymi formatami audio takimi jak podcasty”.

Wyobrażamy sobie trzyosobowy startup w Tallinie, który właśnie pozyskał finansowanie seed na zbudowanie narzędzia do generowania obrazów, teraz zobowiązany do: wdrożenia wielowarstwowego znakowania wodnego, ustanowienia baz danych fingerprinting, stworzenia API wykrywania, przeszkolenia personelu w zakresie dwupoziomowej taksonomii, zaprojektowania dostępnych ikon w wielu językach UE i prowadzenia dokumentacji zgodności dla organów nadzoru rynku.

Uproszczenie, jak się wydaje, jest w oku regulatora.

Treści wygenerowane przez AI będą miały specjalne oznaczenia

Najgłębsza wada Kodeksu Postępowania jest raczej filozoficzna niż techniczna. Zakłada on, że problem treści generowanych przez AI jest przede wszystkim problemem etykietowania — że gdyby tylko obywatele wiedzieli, które obrazy są syntetyczne, podejmowaliby lepsze decyzje.

Jest to, w najlepszym wypadku, optymistyczne. Historia ostrzeżeń o treści, od paczek papierosów po bannery zgody na ciasteczka, sugeruje, że ludzie są niezwykle wprawni w ignorowaniu ujawnień. Własne mechanizmy zgody RODO Unii Europejskiej wyszkoliły całe pokolenie w klikaniu „Akceptuj wszystko” bez czytania. Nie ma powodu sądzić, że ikona „AI” poradzi sobie lepiej.

Co bardziej fundamentalne, Kodeks adresuje problem, który szybko staje się przestarzały. Kiedy każda fotografia została wzmocniona przez AI, kiedy każdy tekst został zredagowany przez AI, kiedy granica między „autentycznym” a „syntetycznym” rozpuściła się w kontinuum współpracy maszyna-człowiek — co dokładnie jest ujawniane? Że inteligencja, sztuczna lub inna, była zaangażowana w tworzenie? To opisuje zasadniczo wszystkie współczesne treści.

Droga naprzód

Autorzy zapraszają do „pisemnych uwag do 23 stycznia 2026″ i obiecują „dalsze udoskonalenie” Kodeksu w kolejnych iteracjach. Biorąc pod uwagę obecny zakres dokumentu, człowiek drży na myśl o udoskonaleniu. Może dedykowany aneks o odpowiednim umiejscowieniu ikony dla wygenerowanych przez AI list zakupów. Podśrodek dotyczący deepfake’owych memów w czatach grupowych. Zharmonizowana taksonomia rozróżniania dzieł „satyrycznych” od „komicznych”.

Unia Europejska wyprodukowała, w tym Kodeksie Postępowania, dokument o prawdziwej ambicji i znacznej szczerości. Reprezentuje tysiące godzin pracy ekspertów szczerze zatroskanych o integralność ekosystemu informacyjnego.

To nie zadziała.

Nie dlatego, że autorzy są głupi — nie są — ale dlatego, że próbują regulować zjawisko, które porusza się szybciej niż regulacja, używając narzędzi zaprojektowanych dla świata, który już nie istnieje. Zanim wspólna ikona UE zostanie „dalej zbadana po testach użyteczności i wymaganiach interoperacyjności”, systemy AI, które ma etykietować, ewoluują poza rozpoznawalność.

Ale grupy robocze będą się spotykać, taksonomie będą się mnożyć, a gdzieś w Brukseli przewodniczący lub wiceprzewodniczący doda kolejny podśrodek do wciąż rosnącej budowli. Jest to, na swój sposób, bardzo ludzka odpowiedź na nieludzkie wyzwanie.

Można by to nawet nazwać wzruszającym.

Sztuczna inteligencja – moje wybrane publikacje

Iluzja Umysłu

Iluzja Umysłu: Jak Antropomorfizujemy Sztuczną Inteligencję – w naszym zapale do ogłaszania postępu technologicznego rozwinęliśmy osobliwy nawyk przypisywania maszynom cech podobnych do ludzkich. Chatbot udaje, że myśli – modele językowe potrafią przekonująco symulować rozumowanie, ale robią to tylko poprzez statystyczne dopasowywanie wzorców.

Poznaj LLM – Efekt Dunninga-Krugera w Krzemie – ta poznawcza deformacja, w której osoby o ograniczonej wiedzy przeceniają swoje kompetencje, znalazła najbardziej wyrafinowane wcielenie nie w psychologii ludzkiej, ale w neuronowych architekturach wielkich modeli językowych. Im większa pewność siebie AI, tym mniejsza powinna być nasza.

Zagadka Świadomości: Filozoficzne Zombie i Przyszłość Sztucznej Inteligencji czeka na rozwiązanie – w rozległym krajobrazie dociekań filozoficznych niewiele koncepcji wywołało tak głęboką debatę. Czy AI może być świadome, czy tylko udaje tak dobrze, że przestaje to mieć znaczenie?

Świadomość jako Zjawisko Kwantowe: Kwantowa Sygnatura Umysłu – twój mózg waży trzy funty i działa na dwudziestu watach – mniej energii niż żarówka. Jednak ten trzykilogramowy organ dostarcza czegoś, czego nie może odtworzyć żaden superkomputer.

Odkryj Mechaniczną Wyrocznię: Filozoficzny Kryzys Sztucznych Umysłów – gdy badamy niedawno ujawniony prompt systemowy DeepSeek, odkryty przez badania bezpieczeństwa Wallarm, stajemy twarzą w twarz z kryzysem sztucznych umysłów, które rozmawiają jak ludzie, ale nie rozumieją ani słowa z tego, co mówią.

Gdy Maszyny Oceniają Własne Dusze – w lśniących laboratoriach Uniwersytetu Nowojorskiego badacze prowadzą coś, co można nazwać mechanicznymi sesjami terapeutycznymi: pytają sztuczną inteligencję o jej wewnętrzne doświadczenia, proszą o introspekcję.

Granice Poznania

Test Turinga w Erze Papug Stochastycznych: Krytyczne Przewartościowanie – w 1950 roku Alan Turing zaproponował to, co stało się jednym z najbardziej wpływowych i dyskutowanych testów w historii sztucznej inteligencji. Test, który można zdać przez udawanie, traci swój sens.

Przeczytaj o Zasadzie Nieoznaczoności AI: LLM-y Wiedzą, Że Zgadują, Ale Nie Powiedzą Ci – zauważyłeś kiedyś, jak ChatGPT brzmi równie pewnie, wyjaśniając fizykę kwantową, jak rekomendując klej na pizzę? To nie przypadek. Prawdziwa niepewność ukryta za fasadą pewności siebie.

Miraż Rozumowania AI: Gdy Modele Myślą Jedno, Ale Mówią Drugie – gdy prosisz AI o rozwiązanie problemu matematycznego i przeprowadza cię przez swoje rozumowanie krok po kroku, co jeśli powiem ci, że AI może wymyślać cały ten łańcuch rozumowania po tym, jak już zna odpowiedź?

Przebudzenie Informacji: Od Średniowiecznego Logosu do Kwantowych Bitów Wheelera – w 1989 roku John Archibald Wheeler, jeden z najbardziej wpływowych amerykańskich fizyków teoretycznych, zaproponował radykalną ideę: rzeczywistość nie jest fundamentalna – informacja jest.

Daremność Przewidywania Odległej Przyszłości: – w świecie zahipnotyzowanym postępem technologicznym istnieje osobliwa obsesja dokładnego przewidywania, kiedy maszyny osiągną świadomość.

Prawda o Branży AI

Za błyszczącymi prezentacjami i astronomicznymi wycenami kryje się brutalnie prosta rzeczywistość: większość dzisiejszych obietnic AI to magiczna maszynka do generowania pieniędzy.

Iluzje Doliny Krzemowej

Magiczna Maszynka Kapitałowa Doliny Krzemowej: Jak GPT-4.5 Zamienia Niejasne Obietnice w Złoto Venture Capital – w nieustającej pogoni Doliny Krzemowej za olśnieniem inwestorów technologicznymi superlatywami, OpenAI ponownie dało popis. Poznaj mechanikę, dzięki której niedoprecyzowane wizje warte są miliardy.

Przechylanie Szali Rzeczywistości: Jak Badania nad AI Obnażają Iluzję Branży Wartą Miliardy Dolarów – w niedawnym raporcie, który wywołał falę w starannie kultywowanym polu zniekształcenia rzeczywistości Doliny Krzemowej, grupa badaczy akademickich przedstawiła coś niezwykłego: rzeczywiste dane.

Historyczna Ugoda Anthropic: Zakład o 1,5 Miliarda Dolarów a Przyszłość AI – latem 2025 roku, gdy firmy zajmujące się sztuczną inteligencją w Dolinie Krzemowej świętowały swoje najnowsze przełomy, Anthropic zawarło ugodę, która może zdefiniować przyszłość branży.

Kontrowersje i Punkty Krytyczne

Dylemat Papugi Stochastycznej: Dlaczego Kontrowersje Wokół Groka Całkowicie Chybią Celu – histeria wokół krótkiego wypadu Groka na kontrowersyjne terytorium ujawnia fundamentalne niezrozumienie tego, czym są wielkie modele językowe.

Kiedy Chatbot Mówi Płynnie w Nowomowie – Blues Dwujęzyczności: Gdy Maszyny Uczą Się Papugować w Dwóch Językach. American Security Project opublikował raport, który powinien niepokoić każdego, kto wierzy w transparentność AI.

Kumbaya AI: Why Singing Digital Campfire Songs with China Won’t Work (Or: How I Learned to Stop Worrying and Love the AI Arms Race) – odpowiedź na technologiczny „plan pokojowy” MIT Technology Review. Naiwność technologicznego pacyfizmu w erze geopolitycznej rywalizacji.

Prawo Wobec AI: Kiedy Systemy Prawne Spotykają Maszynę

Prawo nigdy nie było gotowe na AI. Wieki zasad o autorstwie, odpowiedzialności i świadomości nagle tracą grunt pod nogami.

Podstawy Prawne i Filozoficzne

Poza Iluzją: Co Każdy Prawnik Musi Wiedzieć o Fundamentalnych Ograniczeniach AI – wyobraź sobie osobę w zamkniętym pokoju, otrzymującą przez szczelinę kartki z chińskimi znakami. Zanim zaufasz AI w sprawach prawnych, musisz zrozumieć, dlaczego nie może ono naprawdę „zrozumieć” prawa.

Cicha Kapitulacja: Atrofia Poznawcza Sądownictwa w Erze AI – gdy sądy na całym świecie przyjmują narzędzia AI w celu zwiększenia efektywności i spójności, stają przed podstępnym paradoksem. Gdy sędziowie przestają myśleć i zaczynają ufać algorytmom.

Rekursywna Korupcja Wiedzy Prawnej: Gdy Halucynacje AI Stają Się Częścią Wiedzy Prawniczej – skala dezinformacji prawnej generowanej przez AI nie jest już teoretyczna – ma wymierne, udokumentowane konsekwencje. Samospełniająca się przepowiednia systemowych błędów.

Świadomość Maszyny? Dlaczego Nie Możemy Ufać Własnym Raportom AI – spędziłem znaczny czas na przedstawianiu fundamentalnych różnic między inteligencją biologiczną a sztuczną, ale teraz musimy zmierzyć się z jeszcze bardziej niepokojącym pytaniem.

Przełomowe Sprawy i Decyzje

Bartz przeciwko Anthropic PBC (3:24-cv-05417): Gdy AI Spotyka Prawo Autorskie – Analiza Przełomowego Orzeczenie Sędziego Alsupa – 23 czerwca 2025 roku sędzia William Alsup wydał pierwsze federalne orzeczenie dotyczące tego, czy szkolenie AI na chronionych prawem autorskim dziełach stanowi dozwolony użytek.

AI w Sądzie: Globalna Rewolucja Praw Autorskich i Wyroki, Które Zmienią Wszystko – w marcu 2025 roku Sąd Apelacyjny USA dla Okręgu Kolumbia wydał przełomowe orzeczenie w sprawie stanowiska Urzędu Praw Autorskich USA dotyczącego twórczości generowanej przez AI.

Iluzja Kontroli: Krytyczna Analiza Stanowiska Urzędu Praw Autorskich wobec Dzieł Generowanych przez AI – raport Urzędu Praw Autorskich USA z stycznia 2025 roku dotyczący dzieł generowanych przez AI reprezentuje kluczowy moment. Czy maszyna może być autorem?

Artystyczne Pretensje Doliny Krzemowej: O AI, Prawach Autorskich i Śmierci Doktryny Fair Use – w wielkim teatrze technokapitalizmu rozgrywa się najbardziej osobliwy spektakl: OpenAI, ze wszystką pompą posiadacza skarbów, twierdzi, że stworzenie wartości o wartości miliardów dolarów poprzez masowe kopiowanie czyjejś pracy stanowi „transformatywny” dozwolony użytek.

Dzień, w Którym Maszyny Straciły Głos: Dlaczego tekst Generowany przez Chatboty AI Nie Jest Objęty Konstytucyjną Ochroną Wolności Słowa – w przełomowym orzeczeniu, które może na nowo ukształtować cyfrowy krajobraz, sędzia federalny na Florydzie właśnie orzekł, że chatboty AI nie mają praw wynikających z Pierwszej Poprawki.

Sztuczna Inteligencja a Ochrona Praw Autorskich – kompleksowe spojrzenie na to, jak AI zmusza nas do przedefiniowania własności intelektualnej w erze, gdy maszyny tworzą więcej niż ludzie.

Prywatność i Przywileje

Nieuniknione Zderzenie: Dlaczego Objęcie Komunikacji z AI Tajemnicą Korespondencji Jest Nieuniknione – prawo porusza się wolno, dopóki nie zaczyna. Przez lata sądy odrzucały ideę, że komunikacja cyfrowa zasługuje na specjalną ochronę – dopóki nie uznały, że e-mail zasługuje na taką samą ochronę prywatności jak papierowe listy.

Wielki Brat Wie, Co Promptujesz: Prywatność w Erze AI – Forbes ujawnił sprawę z Maine – United States v. [REDACTED] – która powinna wywołać zimny dreszcz u każdego, kto kiedykolwiek rozmawiał z chatbotem AI.

Psychologia Maszyn i Ludzi

AI nie tylko przetwarza dane – kształtuje ludzi, ich zachowania i przekonania w sposób, którego jeszcze nie do końca rozumiemy.

Manipulacje i Wpływy

Psychologia Manipulacji Maszynowej: Gdy Modele AI Padają Ofiarą Starożytnych Ludzkich Tricków – niedawne badania bezpieczeństwa Cisco ujawniają coś niepokojącego o sztucznej inteligencji: te same techniki manipulacji psychologicznej, które omijają ludzki osąd, działają z niszczycielską skutecznością przeciwko systemom AI.

Łańcuchy Dostaw AI i Incepcja 2.0: Wpajanie Idei w Podświadomość AI – niedawno opublikowana przez National Institute of Standards and Technology taksonomia „Adversarial Machine Learning” ujawnia coś fascynującego: możemy wpajać idee w „podświadomość” AI.

Jak Modele Językowe Postrzegają Sprawy Światowe: Ukryta Siła Uprzedzeń w Treningu AI – w badaniu, które czyta się jak szczyt dyplomatyczny między sztucznymi inteligencjami, badacz Sinan Ülgen przeprowadził fascynujący eksperyment.

Psychologia AI

Nepotyzm AI: Badanie, Które Ujawnia Plemienne Instynkty AI – artykuł badawczy opublikowany w lipcu w Proceedings of the National Academy of Sciences zawiera odkrycia, które powinny sprawić, że każdy używający asystentów AI zatrzyma się w połowie promptu.

Regulacje i Standardy Globalne

Gdy rządy próbują okiełznać AI, ujawniają się fundamentalne rozbieżności w wizji przyszłości.

Geopolityka AI

Plan Działania AI Prezydenta Trumpa: Jak UE Przegrała Bitwę o Globalne Standardy – zderzenie między planem działania AI Ameryki a aktem AI Unii Europejskiej reprezentuje coś więcej niż rozbieżność regulacyjną. Brukselski Efekt rozbił się o amerykański pragmatyzm technologiczny.

Społeczne i Kulturowe Konsekwencje

AI to nie tylko technologia – to lustro, w którym odbijają się nasze najgłębsze przekonania, lęki i nadzieje.

Panika i Reakcje

Wielka Panika Wokół Generowania Tekstu przez AI: Współczesne Polowanie na Czarownice – w czcigodnych salach akademii zachodzi osobliwa inwersja. Tak jak średniowieczni mnisi obawiali się, że druk zniszczy kulturę pamięci.

Dlaczego Pytanie Chatbota AI LLM o Poradę to Jak Konsultacja z Tablicą Ouija – szał wokół AI – miliony skądinąd racjonalnych ludzi zaczęło pytać maszyny do autouzupełniania o radę życiową, strategiczne wskazówki i głęboką mądrość.

Inteligencja Bez Dojrzałości

Inteligencja Bez Dojrzałości: Pustka Filozoficzna w Etyce AI – w styczniu 2017 roku, w historycznym ośrodku konferencyjnym Asilomar w Kalifornii, ponad 100 czołowych ekspertów AI, etyków i badaczy zebrało się, aby stawić czoła jednemu z najbardziej palących pytań naszych czasów.

Założyciel i partner zarządzający kancelarii prawnej Skarbiec, uznanej przez Dziennik Gazeta Prawna za jedną z najlepszych firm doradztwa podatkowego w Polsce (2023, 2024). Doradca prawny z 19-letnim doświadczeniem, obsługujący przedsiębiorców z listy Forbesa oraz innowacyjne start-upy. Jeden z najczęściej cytowanych ekspertów w dziedzinie prawa handlowego i podatkowego w polskich mediach, regularnie publikujący w Rzeczpospolitej, Gazecie Wyborczej i Dzienniku Gazecie Prawnej. Autor publikacji „AI Decoding Satoshi Nakamoto. Sztuczna inteligencja na tropie twórcy Bitcoina” oraz współautor nagrodzonej książki „Bezpieczeństwo współczesnej firmy”. Profil na LinkedIn: 18.5 tys. obserwujących, 4 miliony wyświetleń rocznie. Nagrody: czterokrotny laureat Medalu Europejskiego, Złotej Statuetki Polskiego Lidera Biznesu, tytułu „Międzynarodowej Kancelarii Prawniczej Roku w Polsce w zakresie planowania podatkowego”. Specjalizuje się w strategicznym doradztwie prawnym, planowaniu podatkowym i zarządzaniu kryzysowym dla biznesu.